IT | 스테이블 비디오 디퓨전(Stable Video Diffusion) 최적화, 엔비디아 텐서 RT로 비디오 생성형 AI 가속화

엔비디아(www.nvidia.co.kr)가 엔비디아 텐서RT(NVIDIA TensorRT) 소프트웨어 개발 키트에 비디오 생성형 AI 모델인 스테이블 비디오 디퓨전(Stable Video Diffusion)이 최적화됐다고 밝혔다.

생성형 AI가 발전하고 산업 전반에 걸쳐 널리 보급되면서 로컬 PC와 워크스테이션에서 생성형 AI 애플리케이션을 실행하는 것이 점점 더 중요해지고 있다. 로컬 추론은 지연 시간을 줄이고 네트워크에 대한 의존성을 없애며 데이터를 더욱 잘 제어할 수 있도록 지원한다.

엔비디아 지포스(GeForce)와 엔비디아 RTX GPU에는 로컬에서 생성형 AI를 실행하도록 강력한 성능을 제공하는 AI 전용 하드웨어 가속기인 텐서 코어(Tensor Core)가 탑재된다.

스테이블 비디오 디퓨전은 이제 엔비디아 텐서RT 소프트웨어 개발 키트에 최적화됐다. 엔비디아 텐서RT 소프트웨어 개발 키트는 1억 대 이상의 윈도우 PC와 RTX 기반 워크스테이션에서 최고 성능의 생성형 AI를 구현한다.

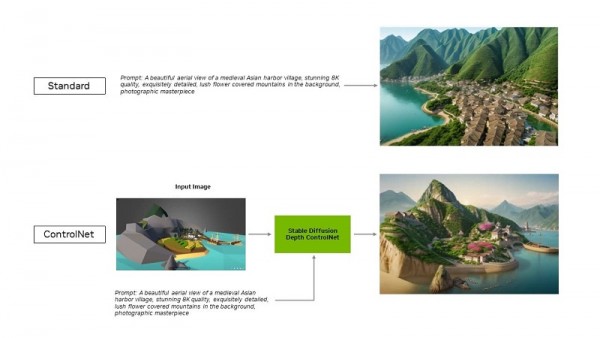

또한 오토매틱1111(Automatic1111)의 인기 있는 스테이블 디퓨전 웹UI용 텐서RT 확장 기능에 컨트롤넷(ControlNets)에 대한 지원이 추가된다. 컨트롤넷은 사용자가 다른 이미지를 참고 자료로 추가해 생성 결과물을 더 세밀하게 제어할 수 있는 도구이다.

텐서RT 가속은 내부 테스트 결과 실제 성능을 정확하게 재현하는 것으로 알려진 UL의 새로운 프로시온 AI(Procyon AI) 이미지 생성 벤치마크에서 확인해 볼 수 있다. 가장 빠른 비 텐서RT 실행과 비교했을 때, 지포스 RTX 4080 슈퍼(RTX 4080 SUPER) GPU에서 50%의 속도 향상을 보였다.

더욱 효율적이고 정확한 AI

개발자는 텐서RT를 통해 완전히 최적화된 AI 경험을 제공하는 하드웨어에 액세스할 수 있다. AI 성능은 일반적으로 다른 프레임워크에서 애플리케이션을 실행할 때보다 두 배 향상된다.

또한 스테이블 디퓨전과 SDXL 등 가장 인기있는 생성형 AI 모델을 가속화한다. 스태빌리티 AI(Stability AI)의 이미지 기반 비디오 생성 AI 모델인 스테이블 비디오 디퓨전은 텐서RT를 통해 40%의 속도 향상을 실현한다.

최적화된 스테이블 비디오 디퓨전 1.1 이미지 투 비디오(Image-to-Video) 모델은 허깅 페이스(Hugging Face)에서 다운로드할 수 있다.

아울러 스테이블 디퓨전 웹UI용 텐서RT 확장 프로그램은 성능을 최대 2배까지 향상시켜 스테이블 디퓨전 워크플로우를 크게 간소화한다.

텐서RT 최적화는 확장 기능의 최신 업데이트를 통해 조건을 추가했다. 이를 통해 텐서RT는 확산 모델의 출력을 안내하는 AI 모델 세트인 컨트롤넷으로 확장된다. 따라서 텐서RT를 사용하면 컨트롤넷의 속도가 40% 빨라진다.

향상된 맞춤화를 위해 컨트롤넷으로 확장된 텐서RT 최적화

사용자는 입력 이미지와 일치하도록 출력의 일부분을 조정할 수 있으므로 최종 이미지를 더 세밀하게 제어할 수 있다. 또한 여러 개의 컨트롤넷을 함께 사용해 더욱 강력한 제어가 가능하다. 컨트롤넷은 뎁스 맵(depth map), 엣지 맵(edge map), 노멀 맵(normal map) 또는 키포인트 감지 모델(keypoint detection model) 등으로 사용할 수 있다.

지금 깃허브(GitHub)에서 스테이블 디퓨전 웹UI용 텐서RT 확장 프로그램 다운로드가 가능하다.

텐서RT로 가속화된 다른 인기 앱

블랙매직 디자인(Blackmagic Design)은 다빈치 리졸브(DaVinci Resolve)의 18.6 업데이트에서 엔비디아 텐서RT 가속화를 채택했다. 매직 마스크(Magic Mask), 스피드 워프(Speed Warp), 슈퍼 스케일(Super Scale)과 같은 AI 도구는 RTX GPU에서 맥(Mac) 대비 50% 이상, 최대 2.3배 더 빠르게 실행된다.

또한, 토파즈 랩스(Topaz Labs)는 텐서RT 통합을 통해 포토 AI(Photo AI)와 비디오 AI(Video AI) 앱의 성능이 최대 60% 향상됐다. 여기에는 사진 노이즈 제거, 선명도 조정, 사진 초고해상도, 비디오 슬로우 모션, 비디오 초고해상도, 비디오 안정화 등이 포함되며, 모두 RTX에서 실행된다.

텐서 코어와 텐서RT 소프트웨어를 결합하면 로컬 PC와 워크스테이션에 탁월한 생성형 AI 성능을 제공할 수 있다. 또한 로컬에서 실행하면 다음과 같은 이점을 누릴 수 있다.

· 성능: 전체 모델이 로컬에서 실행되면 지연 시간이 네트워크 품질과 무관하기 때문에 사용자는 더 짧은 지연 시간을 경험할 수 있다. 이는 게임이나 화상 회의와 같은 실시간 활용 사례에서 유용하다. 엔비디아 RTX는 가장 빠른 AI 가속기를 제공하며 초당 1,300조 회 이상의 연산, 즉 TOPS로 확장 가능하다.

· 비용: 사용자는 거대 언어 모델(large language models, LLM) 추론을 위한 클라우드 서비스, 클라우드 호스팅 애플리케이션 프로그래밍 인터페이스 또는 인프라 비용을 지불할 필요가 없다.

· 상시 가동: 사용자는 고대역폭 네트워크 연결에 의존하지 않고도 어디에서나 LLM 기능에 액세스할 수 있다.

· 개인정보 보호: 개인 혹은 독점 데이터는 항상 사용자의 디바이스에 보관할 수 있다.

LLM을 위한 최적화

텐서RT가 딥 러닝에 제공했던 것을 엔비디아 텐서RT-LLM이 최신 LLM에 제공한다.

텐서RT-LLM은 LLM 추론을 가속화하고 최적화하는 오픈 소스 라이브러리로써, 파이-2(Phi-2), 라마 2 (Llama2), 젬마(Gemma), 미스트랄(Mistral), 코드 라마(Code Llama)를 비롯한 인기 커뮤니티 모델에 대한 기본 지원을 포함한다. 개발자와 크리에이터부터 기업 직원과 일반 사용자에 이르기까지 누구나 엔비디아 AI 파운데이션 모델(AI Foundation models)에서 텐서RT-LLM에 최적화된 모델을 사용해 볼 수 있다. 이와 더불어, 엔비디아 챗RTX(ChatRTX) 기술 데모를 통해 사용자는 윈도우 PC에서 로컬로 실행되는 다양한 모델의 성능을 확인할 수 있다. 챗RTX는 RTX GPU에서 최적화된 성능을 위해 텐서RT-LLM을 기반으로 구축됐다.

엔비디아는 오픈 소스 커뮤니티와 협력해 라마인덱스(LlamaIndex)와 랭체인(LangChain) 등 인기 애플리케이션 프레임워크에 대한 네이티브 텐서RT-LLM 커넥터를 개발하고 있다.

이러한 혁신을 통해 개발자는 애플리케이션에서 텐서RT-LLM을 쉽게 사용하고 RTX로 최고의 LLM 성능을 경험할 수 있다.

AI 디코디드(AI Decoded) 뉴스레터를 구독하면 매주 관련 소식을 이메일로 직접 받아볼 수 있다.

엔비디아, NVIDIA, 텐서RT, NVIDIA TensorRT, 소프트웨어 개발 키트, 비디오 생성형 AI 모델, 스테이블 비디오 디퓨전, Stable Video Diffusion, 최적화