IT | 클라우드부터 PC에 이르는 전 영역에서 AI 구현, AMD AI Business Overview

AMD는 2024년 3월 20일(수) 오전 인공지능(AI)에 대한 하드웨어 및 소프트웨어 지원과 AI 전략 등에 대한 전반적인 내용을 다룬 AMD AI Business Overview를 개최했다.

이날 개최한 AMD AI Business Overview에는 AMD 코리아 커머셜 세일즈 이재형 대표, AMD 코리아 데이터센터 및 클라우드 솔루션 아키텍트 등 커머셜 비즈니스 부분 기술 영업 엄부 담당인 김홍필 이사, 한국 내 컨슈머팀 세일즈 및 마케팅 담당인 임태빈 이사가 참여해 AMD가 나아가는 AI의 방향과 전략, 하드웨어 및 소프트웨어 지원과 최적화, AI 가속기와 APU 등 제품군에 대한 소개도 이어졌다.

현재 인공지능(AI)는 50년 만에 등장한 가장 혁신적인 기술로 불리고 있는 가운데 모바일 및 PC로 구현 가능한 온비디아스 AI 실현, 인간의 사고에 보다 가까운 AI의 등장을 위한 연구도 활발하게 진행 중이다. AMD는 지난 1년 전만 하더라도 데이터센터용 AI 가속기 시장은 연간 50%가 성장했으나 현재는 연간 70% 이상의 성장이 예상되고 있으며 2023년에는 450억 달러에서 4년 후인 2027년에는 4000억 달러 이상에 이를 것으로 전망했다.

AMD는 이러한 AI 시장의 성장과 기술 발전을 기반으로 늘어나고 있는 수요에 대비해 다양한 것을 준비해오고 있다고 전했다. 특히 AMD는 AI 인프라 모든 영역에 걸친 엔드-투-엔드 솔루션을 공급 가능한 기업 중의 하나다. 클라우드부터 고성능 컴퓨팅(HPC), 엔터프라이즈, 임베디드와 PC에 이르는 전 영역에서 AI를 구현할 수 있는 제반 환경을 갖추고 있다.

AMD 코리아 커머셜 비즈니스 부분 기술 영업 엄부 담당 김홍필 이사

AMD는 광범위한 훈련 및 추론 컴퓨팅 엔진 포트폴리오와 개방적이고 검증된 소프트웨어 역량, 기술 혁신을 위해 헙업하는 AI 생태계를 바탕으로 AI를 발전시켜나가고 있다.

AI 기술 발전이 빠르게 진행되면서 AI 가속기는 시장에서 없어서는 안될 중요한 하드웨어 요소 중의 하나이고 경쟁사에서도 없어서 못팔 정도로 수요와 대기 수요는 끝을 모르고 있다. AMD도 이러한 AI 가속기의 중요성과 존재를 알고 지속적인 기술 개발과 제품을 공급하고 있다. 데이터 센터의 AI 워크로드 지원이 가능하며 대표적인 AI 가속기 중 하나인 AMD 인스팅트 MI300 시리즈 가속기도 공급을 계획하고 있다.

AMD 인스팅트 MI300 시리즈 가속기는 데스크탑용 GPU가 RDNA 3 아키텍처로 게이밍에 특화된 것과 같이 차세대 AI 가속기 아키텍처로 CDNA 3를 지원한다. 이는 AI 및 HPC 전용 가속기 엔진이면서 4세대 AMD 인피니티 아키텍처 기반 3.5D 패키징, 최적의 성능과 전력 효율성을 제공하는 것이 특징이다.

그 중 AMD 인스팅트 MI300X는 업계 최고 수준의 생성형 AI 가속기 중의 하나다. AMD CDNA 3 아키텍처 기반으로 192GB HBM3 메모리 탑재, 최대 5.3TB/s 메모리 대역폭, 최대 896GB/s AMD 인피니티 패브릭 대역폭을 통해 대량의 AI 데이터를 처리하는데 특화되어 있다.

최신 AI 가속기 및 GPU는 모듈화를 통해 고성능을 구현하고 있는데 AMD는 빠르게 서버부터 데스크탑, 모바일에 이르기까지 모듈화 구조(MCM, Multi Chip Module)를 도입해왔다. AMD 인스팅트 MI300X 가속기는 304개의 AMD CNDA 3 아키텍처 컴퓨트 유닛을 액셀러레이터 콤플렉스 다이(XCD) x8, I/O 다이(IOD) x4는 256MB AMD 인피니티 캐시와 7 x16 4세대 인피니티 패브릭 링크, HBM3 x8로 192GB, 12단 적층으로 최대 5.3TB/s 대역폭을 제공한다. 이들은 3D 하이브리드 본딩 및 2.5D 실리콘 인터포저를 통해 결합된다.

AMD 인스팅트 MI300X 플랫폼은 8개의 MI300X로 최대 10.4PF(BF16/ FP16), 최고 수준의 메모리 용량인 1.5TB HBM3, 최대 896GB/s 인피니티 패브릭 대역폭을 제공하면서 업계 표준 디자인을 채택하고 있다. MI300X 가속기는 델 테크놀로지스(Dell Technologies), HPE(Hewlett Packard Enterprise), 레노버(Lenovo), 슈퍼마이크로(Supermicro), 에이수스(ASUS), 기가바이트(GIGABYTE) 등 다양한 OEM 및 솔루션 파트너를 통해 공급된다.

또한 AMD는 AMD 인스팅트 MI300A를 세계 최초 AI 및 HPC용 APU 가속기로 소개했다. 5nm 및 6nm 미세 공정, CDNA 3 및 젠4(Zen 4) 아키텍처와 128GB HBM3, CPU+GPU 메모리 공유를 지원해 AI 가속 성능을 향상한다. MI300A 가속기는 6개의 액셀러레이터 콤플렉스 다이(XCD)로 228개의 CDNA 3 컴퓨트 유닛, 3개의 CPU 콤플렉스 다이(CCD)로 24개의 젠4 x86 코어 CPU, 4개의 I/O 다이, 8단 적층 HBM3(최대 5.3TB/s 대역폭), 256MB AMD 인피니티 캐시, 4 x16 4세대 AMD 인피니티 패브릭 링크, 4x16 PCIe 5, 3.5D 패키징(3D 하이브리드 본딩과 2.5D 실리콘 인터포저)으로 제작된다.

MI300A 가속기는 통합 메모리와 AMD 인피니티 캐시 공유 기술, 동적 전력 공유, 용이한 프로그래밍 등 APU의 장점을 통합 새로운 성능과 가능성을 제공한다. 기존 3세대 인피니티 아키텍처에서는 젠3(Zen 3) 기반 3세대 에픽(EPYC)은 CPU 메모리(DDR), AMD CDNA 2 아키텍처 AMD 인스팅트 MI250X는 GPU 메모리(HBM2e)를 각각 갖추고 서로 데이터를 주고 받는 통신이 이루어졌다면 4세대 인피니티 아키텍처에서는 젠4 아키텍처 CPU와 AMD CDNA 3 아키텍처 AI 가속기가 통합 메모리(HBM3)를 공유해 서로의 데이터를 보다 빠르고 효율적으로 통신할 수 있도록 개선됐다.

AMD 인스팅트 MI300A APU는 HPE와 EVIDEN(an atos Business), 기가바이트(GIGABYTE), 슈퍼마이크로(Supermicro) 등의 다양한 OEM 및 솔루션 파트너를 통해 공급된다. 특히 AMD 인스팅트 제품군은 세계 상위 25개 슈퍼컴퓨터 중 5개, 상위 10개 그린 슈퍼컴퓨터 중 6개 시스템을 지원하는 등 전문 분야에서 그 성능이 입증되고 있다.

AI 구현에서 하드웨어 분야는 AI 가속기가 중요하지만 이를 뒷받침하는 소프트웨어도 중요하며 AMD는 인스팅트 소프트웨어 생태계를 위한 비전을 실현한다.

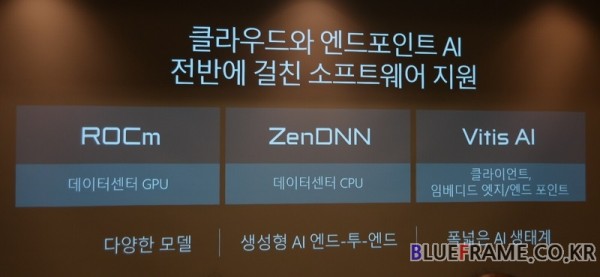

AMD는 데이터센터 GPU는 ROCm, 데이터센터 CPU는 ZenDNN, 클라이언트와 임베디드 엣지/ 엔드 포인트에는 Vitis AI를 각각 도입하고 있으며 다양한 모델과 생성형 AI 엔드-투-엔드, 폭넓은 AI 생태계를 구축하는 등 클라우드와 엔트포인트 AI 전반에 걸친 소프트웨어 지원을 이어가고 있다.

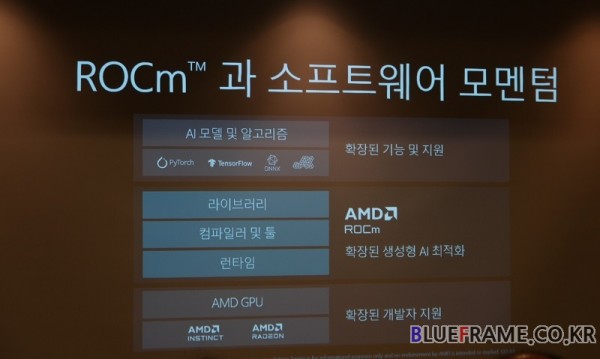

오픈 생태계를 구성하는 ROCm과 소프트웨어는 AI 모델 및 알고리즘에서 확장된 기능 및 지원, 확장된 생성형 AI 최적화로 라이브러리와 컴파일러 및 툴, 런타임을 제공한다. 또 AMD GPU는 AMD 인스팅트(Instinct)와 라데온(Radeon)는 확장된 개발자를 지원한다.

또한 ROCm 6.0 버전에서는 생성형 AI를 위한 새로운 기능을 제공한다. 고급 대규모 언어 모델(LLM) 최적화를 위해 동적 FP16, BF16, FP8을 활용하고 고급 어텐션 알고리즘 및 커널, 콜렉티브 커뮤니케이션, HIP그래프 등을 제공한다. 고성능 AI 라이브러리에서는 컴퓨트 및 대역폭 오퍼레이터, 구조화된 희소성(Structured Sparsity), 양자화 라이브러리 등을 지원한다. 확장된 생태계 지원을 위해 프레임워크와 모델, 머신러닝 파이프라인을 구축한다.

이러한 AMD의 노력으로 ROCm은 기능 개선과 최적화를 통해 LLM 성능의 최적화가 이루어져 최적의 추론 라이브러리(vLLM)은 2.6배(2.6X), 최적의 런타임 HIP그래프는 1.4배(1.4X), 플래시 어텐션은 최적의 커널로 1.3배(1.3X)의 향상이 이루어졌다.

AMD 인스팅트 GPU+ ROCm 플랫폼 세대별로 성능은 MI250X와 ROCm 5 대비 MI300X와 ROCm 6은 Llama 2 70B 추론 테스트에서 8배(8X)의 텍스트 생성 지연 개선(ms)이 이루어졌다.

다양한 산업 분야의 워크로드와 활동을 확장 및 강화하면서 AI는 광범위한 산업에 영향을 미치고 있다. 머신러닝은 개인화 및 단가 최적화, 사기 및 사이버 위협 탐지 개선, 프로세스 및 운영 자동화와 최적화, 연구 속도 가속화와 원활한 인간-기계 커뮤니케이션, 자동 전사 및 요약은 생성형 AI, 사용자 패턴 기반 타겟 상품 추천과 미디어 결합을 통한 고객 상호 작용 및 유치 최적화, 고객 서비스 대응 및 정확성 향상의 추천 시스템 등으로 스트리밍과 게이밍, 공공안전, 제조업, 소매업, 금융 서비스, 의료, 서비스 자동화 등 거의 모든 분야에서 AI의 가능성과 활약이 이어지고 있다.

최상위 수준의 AI 연산을 위한 조건으로는 훈련과 추론, 기존 워크로드 및 데이터 저장소가 갖추어져야 한다. 가장 데이터 및 연산 집약적 단계인 훈련은 언어와 이미지 및 기타 데이터 유형에 대한 AI 시스템의 이해가 필요하다. 훈련된 AI는 비교적 적은 연산 능력으로도 데이터와 비즈니스 기록을 시간으로 처리하는 추론 단계, AI 혁신과 인사이트를 제공하기 위한 기본적인 비즈니스 프로세스 컴퓨팅 및 데이터 소스 공급이 이루어지는 기존 워크로드 및 데이터 저장소가 필요하다.

AMD 에픽 서버 프로세서는 이러한 AI 연산을 위한 다양한 조건을 제공해 업계 최고의 데이터센터 솔루션을 제공한다. AMD 에픽 프로세서 서버는 데이터 센터 AI를 위한 기반이 된다. AI는 다양한 엔터프라이즈 애플리케이션과 산업을 통해 확산 및 보급이 이루어지며 인프라를 에픽 서버에 통합하여 새로운 AI 기술 활용을 위한 공간 및 에너지 확보로 AI 가용 여력을 확보한다. 에픽 서버는 소형 및 중형 AI 모델과 혼합 워크로드에 최적의 옵션을 제공한다. 대규모 AI 배포에 있어 에픽 기반 서버는 AMD 인스팅트, AMD 라데온, 엔비디아 및 기타 GPU 가속을 지원하는 호스트가 된다.

서버용 CPU인 AMD 에픽과 AI 가속기인 AMD 인스팅트는 데이터센터 AI를 위한 AMD 솔루션으로 워크로드에 최적화된 엔진을 통해 모든 요건에 대응하는 엔트투엔드 AI 효율성을 제공한다.

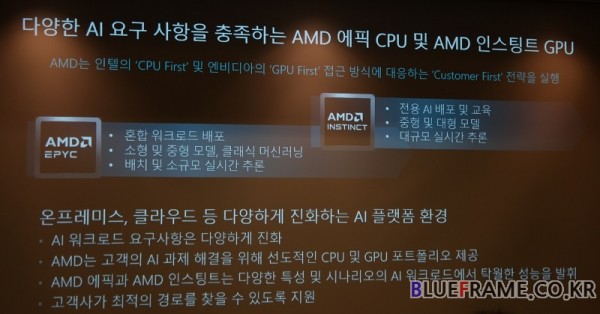

이중 에픽 CPU는 서버로 데이터 센터 AI 이니셔티브를 활성화하며 소형 및 중형 모델, 클래식 머신러닝, 배치 및 소규모 실시간 추론에 적합하다. 또 데이터 센터 내 AI 가용 여력을 제공한다. 업계 최고 수준의 성능과 탁월한 효율성, 새로운 AI 워크로드를 위해 가용한 공간과 비용, 에너지를 제공한다. AI 가속기는 대규모 AI 모델 및 훈련에 보다 적합하다. 검증된 AI 헤드 노드와 GPU 호스트를 통해 높은 성능과 광범위한 확장성, 고성능 GPU와의 검증 및 인증을 제공한다.

AMD는 인텔의 CPU First 및 엔비디아(NVIDIA)의 GPU First 전급 방식에 대응해 Customer First 전략을 도입한다. AMD 에픽 CPU는 혼한 워크로드 배포와 소형 및 중형 모델, 클래식 머신러닝, 배치 및 소규모 실시간 추론에 AMD 인스팅트 AI 가속기는 전용 AI 배포 및 교육, 중형 및 대형 모델, 대규모 실시간 추론에 최적화한다.

이를 통해 온프레미스, 클라우드 등 다양하게 진화하는 AI 플랫폼 환경에 대응한다. AMD는 고객의 AI 과제 해결을 위한 선도적인 CPU 및 GPU 포트폴리오를 제공하고 AMD 에픽과 인스팅트는 다양한 특성 및 시나리오의 AI 워크로드에서 탁월한 성능을 발히해 고객사가 최적의 경로를 찾을 수 있도록 지원한다.

AMD 에픽 프로세서 + GPU 가속은 네이티브 AI 및 대규모 AI 작업에서 테스트를 통해 검증 및 인증된 솔루션이다. 엔비디아 인증을 받은 AM 에픽 9004 기잔 헤드 노드 GPU 시스템(HGX H100 등), 엔비디아 GPU용 AI 헤드 노드 시스템으로 검증 및 인증 받은 에픽 9004 시리즈가 있다. 향후에는 추가 시스템 모델과 추가 OEM, 추가적인 가속기 제품이 더 많은 시스템 및 GPU가 검증 및 인증 받을 예정이다.

한국 내 컨슈머팀 세일즈 및 마케팅 담당 임태빈 이사

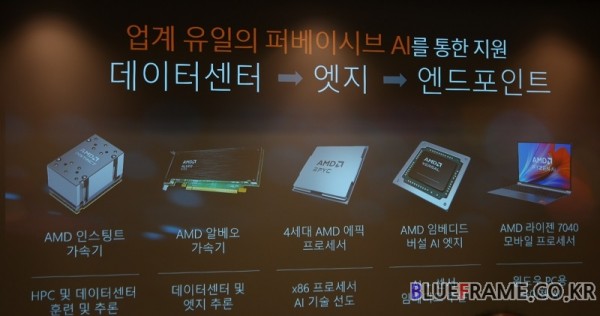

또한 AMD는 라이젠 AI(Ryzen AI)를 통해 모든 사용자를 위한 AI PC 혁신을 가져온다. AMD는 업계 유일의 퍼베이시브 AI를 통한 지원이 이루어진다. 데이터 센터부터 엣지, 엔드포인트에 이르는 다양한 시스템에서 AI 가속을 위한 환경을 마련해준다.

HPC 및 데이터센터 훈련 및 추론에는 AMD 인스팅트 가속기, 데이터센터 및 엣지 추론에는 AMD 알베오 가속기, x86 프로세서 AI 기술은 4세대 AMD 에픽 프로세서가 선도한다. AI + 센서 임베디드 추론은 AMD 임베디드 버설 AI 엣지, 윈도우 PC용 라이젠 AI는 AMD 라이젠 7040 모바일 프로세서를 통해 구현한다.

AMD 라이젠 AI는 개인 사용자용 AI 프로세싱을 지원해 퍼스널 AI 컴퓨팅의 시대를 이끌어간다. 자일링스 인수를 통해 신경망 가속기 NPU는 AMD XDNA, CPU는 AMD 젠(Zen), GPU는 RDNA 아키텍처를 통해 AMD 라이젠 AI를 구축한다.

NPU는 가장 효율적인 모바일 AI 프로세싱을 위한 전용 AI 엔진이며 젠 CPU는 AI 워크로드를 가속화하는 AVX-512 VNNI 명령어를 지원한다. GPU는 RDNA 아키텍처로 병렬 연산 AI 워크로드에 최적화된 AMD 라데온 그래픽 엔진으로 다양한 소프트웨어에서 가속 기능을 제공한다.

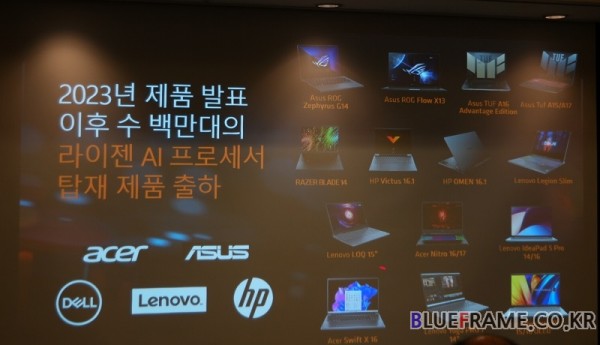

AI PC는 왜 필요한 가에 대한 질문에 AMD 라이젠 AI가 제공하는 장점으로 탁월한 성능, 강력한 보안 기능, 높은 미래 가치, 뛰어는 효율성을 들고 있다. AMD는 라이젠 AI 프로세서를 탑재한 제품을 2023년 제품 발표 이후 수 백만 대에 탑재해 출하하고 있다. 에이스(Acer), 에이수스(ASUS), 델(Dell), 레노보(Lenovo), HP 등의 다양한 노트북 제조사를 통해 제품이 출시되고 있다.

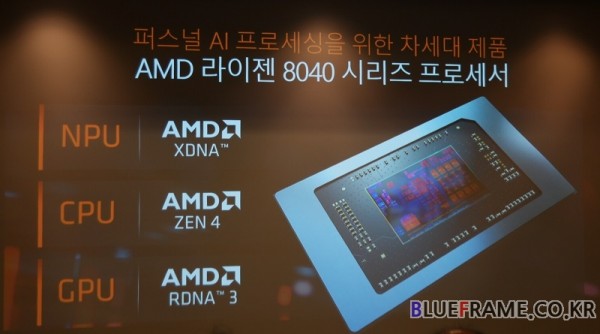

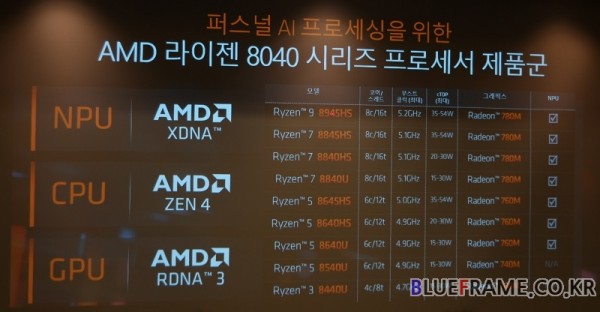

퍼스널 AI 프로세싱을 위한 차세대 제품으로 AMD는 라이젠 8040 시리즈 프로세서를 공개했다. NPU는 XNDA, CPU는 젠4(Zen 4), GPU는 RDNA 3 아키텍처를 지원한다. 라이젠 8040 시리즈는 생성형 AI 지원에서 기존 라이젠 7040 시리즈 대비 개선된 AI 성능을 제공한다. Llama 2와 Vision Models에서 각각 최대 1.4배(1.4X) 향상된 성능을 제공한다. 라이젠 8040 시리즈 중 라이젠 3 8440U와 라이젠 5 8540U에는 NPU가 제외되고 나머지 시리증는 NPU가 탑재된다.

또한 AMD는 2023년 2분기 출시한 피닉스 라이젠 7040 시리즈를 이어 2024년 1분기 출시한 호크 포인트 라이젠 8040 시리즈, 2024년 연내 출시 예상되는 스트릭스 포인트 차세대 AMD 라이젠 AI를 통해 생성형 AI용 차세대 NPU(XDNA 2)를 탑재해 기존 세대 대비 높은 NPU 및 전체 AI 가속 성능을 개선해나갈 예정이다. XDNA 2 아키텍처는 기존 대비 3배의 생성형 AI NPU 성능을 제공한다.

좌측부터 AMD 코리아 커머셜 세일즈 이재형 대표, AMD 코리아 커머셜 비즈니스 부분 기술 영업 엄부 담당 김홍필 이사, 컨슈머팀 세일즈 및 마케팅 담당 임태빈 이사

AMD의 AI 인프라 모든 영역에 걸친 엔드투엔드 솔루션에 대한 소개와 하드웨어 및 소프트웨어 지원 등 앞으로 나아가야할 AI 전략에 대한 소개에 이어 Q&A도 이어갔다.

AMD는 Q&A를 통해 MI300 시리즈 AI 가속기는 없어서 구하기 어렵고 공급 부족을 겪고 있는 경쟁사의 상황에 대해 충분히 공급 가능한 수량을 준비해 공급 부족 현상을 겪지 않게 준비 중이라고 밝혔다.

AMD AI 가속기가 경쟁 AI 가속기 대비 갖는 장점으로 오픈된 소프트웨어 지원 환경과 광범위한 포트폴리오 확보, 높은 에너지 효율성으로 단위 와트 당 능력에 유리하다고 밝혔다. AI 처리에서 발생하는 높은 전력 소모와 발열 등은 현재의 시대와 역행하는 모습인데 AMD는 그런 면에서 에너지를 효과적으로 활용하면서 AI 가속기의 성능을 향상했다.

챗GPT나 이미지 생성을 위한 스테이블 디퓨전 등이 사용자들이 접할 수 있는 부분인데 라이젠 AI의 AI 환경 구현 등 체감 가능한 것이 있느냐에 대해 어도비 프리미어에서 라이젠 AI를 활용하거나 OS 자체 AI로 부팅시 사용자의 최적 환경을 기억해 설정을 이용할 수 있게 해주는 등 다양한 시도가 이루어지고 있어 앞으로 AI를 더욱 가깝게 느낄 수 있게 될 것이라고 전했다.

또한 모듈화 패키지가 업계에서 시도되고 있는데 대해 AMD는 에픽 프로세서 등을 통해 빠르게 다이를 여러 개 연결하는 모듈화 구조인 MCM을 도입하고 패키징화해 경쟁사 대비 더 많은 조합과 하드웨어적인 성과를 내고 있다고 전했다.

한편 AMD는 클라우드와 HPC, 엔터프라이즈, 임베디드, PC에 이르는 AI 인프라 모든 영역에 걸친 엔드투엔드 솔루션 공급이 가능하다고 소개했으나 현재 가시적인 성과를 보여주지 못하고 있는데 대해 2년 전 KT 클라우드를 통해 서비스를 구현하고 공공기관과 쿠폰 이용 등 클라우드로 이미 많이 활용되고 있다고 밝혔다. 연말이 되면 가시적인 성과가 드러날 것으로 보이며 이때 구체적인 수치 등 소개가 가능할 것으로 예상했다.

또 젠 기반 제품군은 데이터 센터에서 획기적인 점유율을 확장했고 이들에 포커스가 맞추어지고 있으며 클라우드부터 확장을 통해 올해는 더 많은 것을 볼 수 있게 될 것이라고 전했다. 2025년에는 AI 전용 노트북 등도 등장이 예상되며 기존 제품들 역시 이들의 혜택을 얻을 수 있을 것으로 전망했다.

AMD, 인공지능, AI, AMD AI Business Overview, 2024, 클라우드, 고성능 컴퓨팅, HPC, 엔터프라이즈, 임베디드, PC, 전 영역, AI 구현