서버 | 데이터센터 AI 솔루션, AMD 인스팅트 MI300 신규 라인업 공개

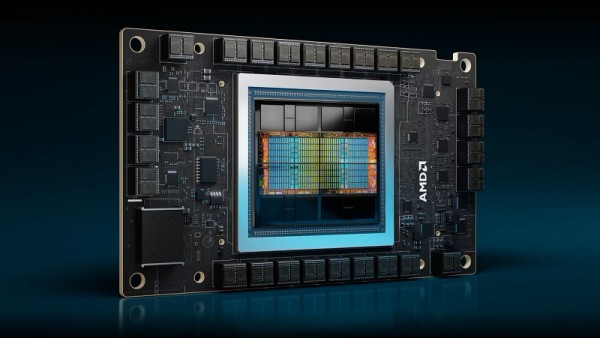

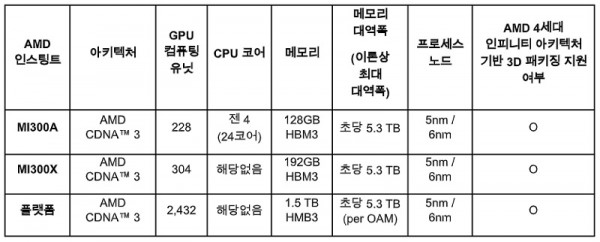

AMD가 AMD 인스팅트 MI300X(AMD Instinct™ MI300X) 가속기 제품군과 AMD 인스팅트 MI300A(AMD Instinct™ MI300A) APU를 출시했다.

인스팅트 MI300X 가속기는 생성형 AI에 적합한 최고 수준의 메모리 대역폭과 LLM(Large Language Model, 대형 언어 모델) 훈련 및 추론에 필요한 고도화된 성능을 제공한다.

또한, 최신 AMD CDNA 3 아키텍처와 젠 4(Zen 4) CPU를 결합한 인스팅트 MI300A APU는 혁신적인 HPC(Hight Performance Computing, 고성능 컴퓨팅) 및 AI 워크로드 처리 능력을 갖췄다.

빅터 펭(Victor Peng) 사장은 “AMD의 최첨단 기술로 탄생한 인스팅트 MI300 시리즈 가속기는 압도적 성능을 바탕으로 향후 대규모 클라우드 및 기업 배포에 활용될 것"이라며 “클라우드 서비스 제공업체나 OEM 및 ODM은 AMD가 제시하는 하드웨어와 소프트웨어 및 개방형 생태계 접근 방식을 활용해 기업이 AI 솔루션을 도입하고 배포할 수 있도록 지원한다”고 덧붙였다.

실제로, 최근 마이크로소프트가 AMD 인스팅트 MI300X 가속기를 탑재해 AI 워크로드에 최적화된 애저 ND MI300x v5 가상머신(Azure ND MI300x v5 Virtual Machine) 시리즈를 선보인 바 있다. 미국 로렌스 리버모어 국립연구소에서는 AMD 인스팅트 MI300A APU가 탑재된 슈퍼컴퓨터 ‘엘 카피탄(El Capitan)’을 사용 중이다. 전체 시스템 구동시 2엑사플롭스(exaFLOPs) 이상의 배정밀도연산 성능을 제공할 것으로 추정되는 엘 카피탄은 세계에서 두 번째로 엑사플롭스 한계를 돌파한 AMD 기반 슈퍼컴퓨터로 기록될 예정이다. 오라클 클라우드 인프라스트럭처(Oracle Cloud Infrastructure; OCI)는 자사 AI용 고성능 가속 컴퓨팅 인스턴스에 AMD 인스팅트 MI300X 기반의 베어 메탈 인스턴스를 탑재할 계획이라 밝혔다. MI300X 기반 인스턴스는 초고속 RDMA 네트워킹으로 향후 OCI 슈퍼클러스터(OCI Supercluster)를 지원한다.

한편, AMD가 6일 (미국 현지 시각 기준) 개최한 ‘어드밴싱 AI(Advancing AI)’ 행사 전후로 주요 OEM사의 가속 컴퓨팅 시스템이 잇달아 공개되었다. 델 테크놀로지스(Dell Technologies)는 총 8대의 AMD 인스팅트 시리즈 가속기가 설치된 델 파워엣지 XE9680(Dell PowerEdge XE9680) 서버와 AMD ROCm(Radeon Open Compute) 기반 AI 프레임워크로 구성된 생성형 AI용 ‘델 검증 설계(Dell Validated Design)’를 새롭게 선보였다. 휴렛팩커드 엔터프라이즈(Hewlett Packard Enterprise; HPE)에서도 최근 AMD 인스팅트 MI300A를 탑재한 최초의 슈퍼컴퓨터 가속기 블레이드 ‘HPE 크레이 슈퍼컴퓨팅 EX255a(HPE Cray Supercomputing EX255a)’의 2024년 초 출시 계획을 공개했다. 레노버(Lenovo)는 2024년 상반기를 목표로 AMD 인스팅트 MI300 시리즈 신형 가속기에 대한 설계 지원을 발표했다.

슈퍼마이크로(Supermicro)는 4세대 AMD 에픽(AMD EPYC™) CPU와 AMD 인스팅트 MI300 시리즈 가속기를 탑재한 H13 가속 서버 신규 런칭 소식을 전했다.

AMD 인스팅트 MI300X 가속기

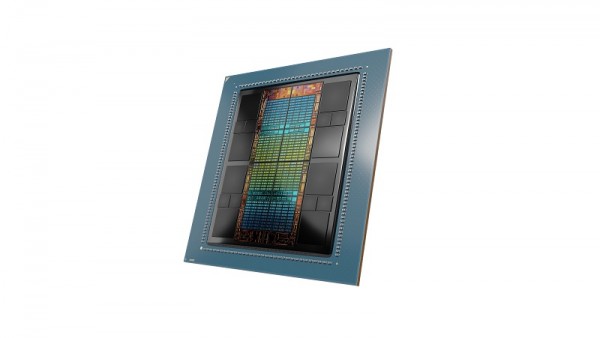

AMD 인스팅트 MI300X

새로운AMD CDNA 3 아키텍처를 기반으로 하는 AMD 인스팅트 MI300X 가속기는 이전 세대인 AMD 인스팅트 MI250X(AMD Instinct™ MI250X) 가속기보다 약 40% 더 많은 컴퓨팅 유닛 1 과 1.5배 큰 용량의 메모리를 장착했다. 이론적인 최대 메모리 대역폭 역시 1.7배 높다. 또한, FP8(8비트 부동 소수점) 및 희소성(sparsity) 같은 새로운 포맷을 지원하여 AI 및 HPC 워크로드에도 완벽하게 대비했다.

최근에는 대형 언어 모델의 크기와 복잡성이 지속적으로 확대되고 있어, 이에 걸맞은 대용량 메모리와 컴퓨팅 성능에 대한 요구도 점차 커져가고 있다. AMD 인스팅트 MI300X 가속기는 고부하 AI 워크로드에 필요한 성능을 제공하기 위해 업계 최고 수준의 192GB HBM3 메모리 용량과 초당 최대 5.3 TB(테라바이트) 데이터 처리가 가능한 메모리 대역폭을 지원한다.

AMD 인스팅트 시리즈는 업계에서도 손꼽히는 생성형 AI 플랫폼으로, 8개의 MI300X 가속기를 결합한 산업 표준 OCP(Open–Closed Principle; 개방-페쇄 원칙) 디자인을 채택해 HBM3 메모리 용량이 1.5TB에 달한다. 산업 표준 디자인을 채택했기 때문에 OEM사는 기존AI 제품에 MI300X 가속기를 설치해 간편하게 운용할 수 있고 AMD 인스팅트 가속기 기반 서버도 더 빠르게 적용할 수 있다.

이를 활용해 블룸 176B(BLOOM 176B) 같은 대형 언어 모델에서 추론을 실행할 경우, 엔비디아 H100 HGX와 비교해 최대 1.6배 향상된 처리량을 제공한다. 이는 라마 2(Llama2) 같은 70B(70억개의 파라미터) 모델 추론을 단일 가속기에서 실행할 수 있는 업계 유일의 옵션이며, 엔터프라이즈급 LLM을 손쉽게 구축하고 총 소유 비용(TCO; Total Cost of Ownership)을 절감할 수 있도록 지원한다.

AMD 인스팅트 MI300A APU

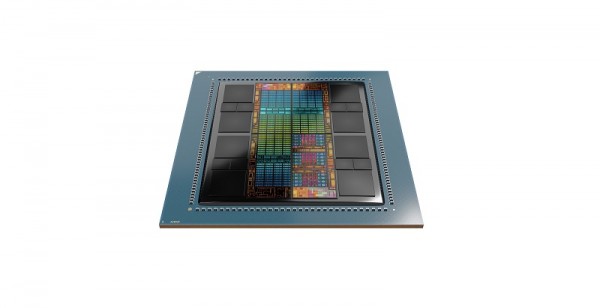

AMD 인스팅트 MI300A

AMD 인스팅트 MI300A APU는 세계 최초의 HPC 및 AI용 데이터센터 APU로, 3D 패키징과 4세대 AMD 인피니티 아키텍처(AMD Infinity Architecture)를 활용, 탁월한 워크로드 처리 능력을 발휘한다. 고성능 AMD CDNA™ 3 GPU 코어와 최신 x86 기반 CPU 코어인 “젠 4”, 128GB용량의 차세대 HBM3 메모리를 결합하여, 기존 AMD 인스팅트 MI250X모델에 비해 FP32 연산HPC 및 AI 워크로드에서 와트당 성능이 약 1.9배 개선되었다.

업계가 에너지 효율성을 최우선시하는데 반해 HPC 및 AI 워크로드는 매우 많은 데이터와 자원을 요구한다. AMD 인스팅트 MI300A APU는 CPU 와 GPU 코어를 단일 패키지에 결합해 효율성을 꾀한 플랫폼이다. 해당 APU의 컴퓨팅 성능으로 최신 AI 모델을 더욱 신속하게 훈련시킬 수 있다. AMD는 자사의 에너지 효율 혁신 목표인 ‘30x25’를 기반으로 2025년까지 AI 훈련 및 HPC용 서버 프로세서와 가속기의 에너지 효율성을 30배로 끌어올릴 계획이다.

인스팅트 MI300A APU는 통합 메모리와 캐시 자원을 통해 고객이 쉽게 프로그래밍할 수 있는 GPU 플랫폼 경험을 제공한다. 고부하 HPC 및 AI 워크로드를 처리할 수 있는 고성능 컴퓨팅과 탁월한 AI 훈련 속도, 에너지 효율성 역시 보장한다.

ROCm 소프트웨어 및 생태계 파트너

AMD는 최신 AMD ROCm 6 개방형 소프트웨어 플랫폼(AMD ROCm™ 6 open software platform) 발표와 함께 오픈소스 커뮤니티에 최첨단 라이브러리 제공을 약속하며 오픈소스 AI 소프트웨어 개발에 대한 AMD의 비전을 다시 한번 공고히 했다.

ROCm 6 소프트웨어는 AMD 소프트웨어 도구가 이뤄낸 의미 있는 발전을 상징적으로 보여준다. 단적으로, 라마 2 텍스트 생성시MI300 시리즈 가속기는 이전 세대 하드웨어 및 소프트웨어와 비교했을 때 약 8배 향상된 AI 가속 성능을 발휘한다.

생성형 AI를 위한 플래시어텐션(FlashAttention), HIPGraph 및 vLLM을 비롯한 다양한 주요 신기능도 지원한다. 즉, AMD는 허깅페이스(Hugging Face), 파이토치(PyTorch), 텐서플로(TensorFlow) 등 널리 사용되는 오픈 소스 AI 소프트웨어 모델과 알고리즘 및 프레임워크를 활용하여 혁신을 주도하고, AMD AI 솔루션 배포를 간소화하며 생성형 AI가 지닌 잠재력을 극대화하고 있다.

AMD는 소프트웨어 스타트업 노드.ai(Nod.ai)와 밉솔로지(Mipsology)를 인수하는 등 소프트웨어 역량 강화에도 꾸준히 투자하고 있다. 또한, 기업 고객 대상으로 LLM을 제공하는 라미니(Lamini), AMD ROCm을 활용해 코드 변경 없이 AMD 인스팅트 가속기의 LLM훈련을 지원하는 모자이크ML( MosaicML )과도 전략적 파트너십을 구축했다.